ローカルAI作曲「ACE-Step」とは|特徴とできること

AIが音楽を作る時代。Suno や Udio などのサービスが広がる一方で、「クラウドに頼らず、自分の環境で音を生みたい」という声も増えています。

ACE-Step は、そんなニーズに応えるオープンソースのAI作曲モデルです。(初回セットアップ後は)ネット接続なしで動作し、無料・商用利用可という自由度の高さが特徴。個人制作のBGMや映像音楽にもすぐ活用できます。

この記事では、ACE-Stepを短時間で導入し、初めてのAI音楽を生成するまでの手順をわかりやすく解説します。初回セットアップ後はローカル完結(オフライン)での利用も可能です。

事前準備|対応OS・推奨環境・公式リンク

ACE-Step はローカル環境で動作するオープンソースの AI 音楽生成モデルです。ここでは、実行に必要な環境と準備条件をまとめます。

推奨環境(OS/CPU/GPU/ Python)

・OS:Windows / macOS / Linux

・Python:3.10 以上が推奨(それ以前でも動作する場合があります)

・GPU:NVIDIA CUDA対応GPUがあれば高速生成が可能です(CPUのみでも動作しますが、処理時間が長くなります)

仮想環境(venv)の使い方[推奨]

Pythonの依存関係を安全に管理するため、venv などの仮想環境を利用することを推奨します。必須ではありませんが、他のプロジェクトと環境を分けることでトラブルを防ぎやすくなります。

公式リンク集(ACE-Step / GitHub / Hugging Face)

・ACE-Step公式サイト:https://ace-step.github.io/

・GitHubリポジトリ:https://github.com/ace-step/ACE-Step

・Hugging Faceモデルページ:https://huggingface.co/ACE-Step

準備が整ったら:

次章では、Gitを使ってモデルを取得し、実際にAIが作曲を行うまでの手順を紹介します。

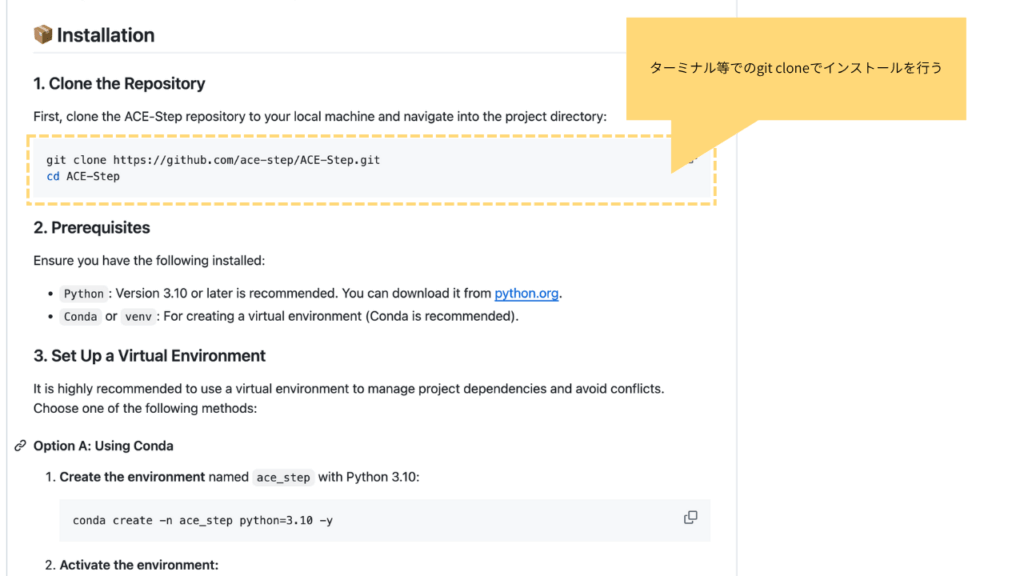

ACE-Stepのインストール手順(Windows / macOS / Linux共通)

ここでは ACE-Step をローカル環境にインストールし、音楽生成を実行できる状態まで整えます。操作は Windows / macOS / Linux 共通 です。

① 作業フォルダを作成する

まず、わかりやすい場所に作業用フォルダを作ります。

| Windows | C:\AI\ACE-Step |

| macOS / Linux | ~/AI/ACE-Step |

ターミナル(またはコマンドプロンプト)を開き、次のように移動します。

# Windows の場合

cd C:\AI

# macOS / Linux の場合

cd ~/AI② モデルの取得(Hugging Faceをgit clone)

ACE-Stepの公式リポジトリはHugging Face上で公開されています。Gitを使ってローカルに複製します。

git clone https://huggingface.co/ACE-Step/ACE-Step-v1-3.5B

cd ACE-Step-v1-3.5BHugging Faceのアカウント登録は不要です。クローンが完了すると、スクリプトとモデル構成ファイルが展開されます。

③ 必要ライブラリのインストール(pip)

ACE-Stepを実行するために、Pythonライブラリをインストールします。

pip install torch transformers accelerate soundfile gradioPyTorchは環境に応じて自動で最適なバージョン(CPU版/GPU版)が選ばれます。GradioはブラウザUIを起動するために使用します。

④ 動作確認(–helpの実行)

インストールが完了したら、次のコマンドでACE-Stepを実行可能か確認します。

python app.py --helpエラーが表示されなければ、環境構築は完了です。

次章では、Gradio UIまたはCLIを使って実際にAI作曲を体験します。

この記事のポイント(30秒で要点)

- ローカル実行&商用可(Apache-2.0)。UI(Gradio)/CLIの両対応。

- 短尺(30〜60秒)のBGMが安定。長尺(〜240秒)は品質が落ちやすい。

- 歌詞→ボーカル生成に対応(整合はプロンプト/シード/環境に依存)。

- 最短導入:

git clone→pip install→python app.py(UI起動)。

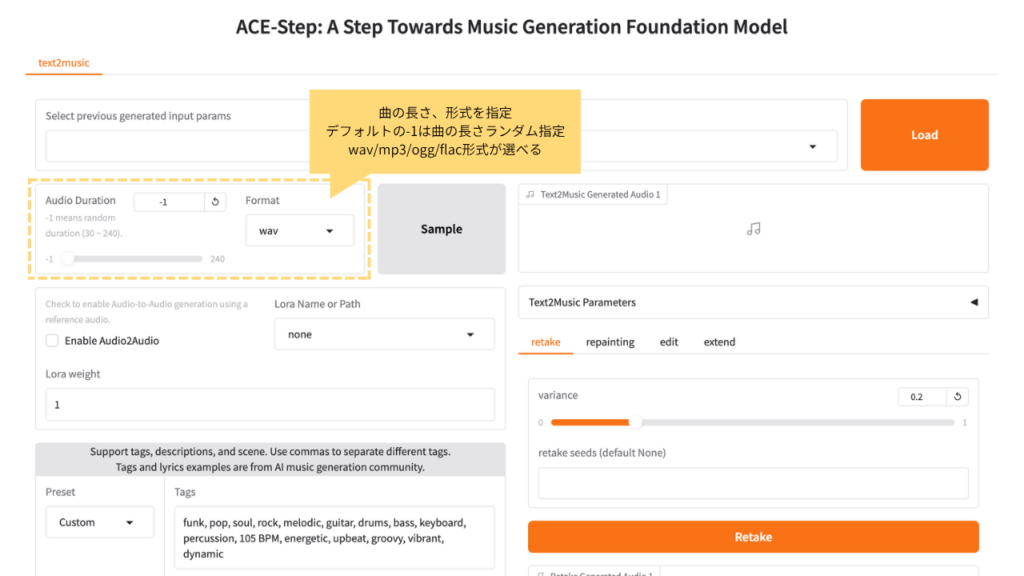

ACE-Stepの使い方|Gradio UIで曲を生成

ACE-Stepには2種類の操作方法があります。

初心者にはブラウザで操作できる Gradio UI が便利ですが、スクリプト制御をしたい場合は CLI(コマンドライン) も利用できます。

Gradio UIの起動方法(http://127.0.0.1:7860)

ターミナルでACE-Stepのフォルダ(例:~/AI/ACE-Step-v1-3.5B)に移動し、次のコマンドを実行します。

python app.py数秒後、次のようなURLが表示されます:

Running on local URL: http://127.0.0.1:7860/ブラウザで http://127.0.0.1:7860/ を開くと、Gradio UIが起動します。

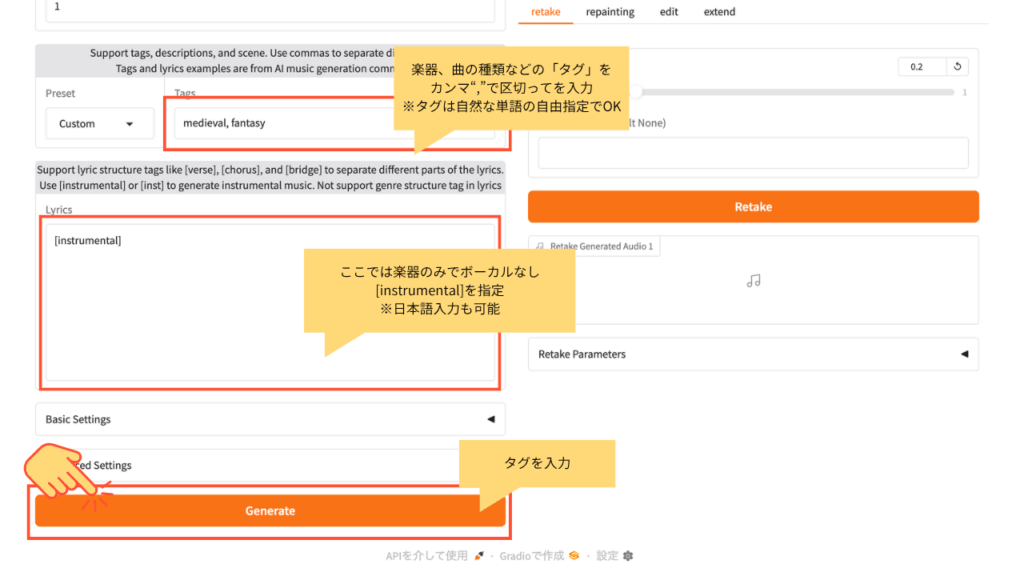

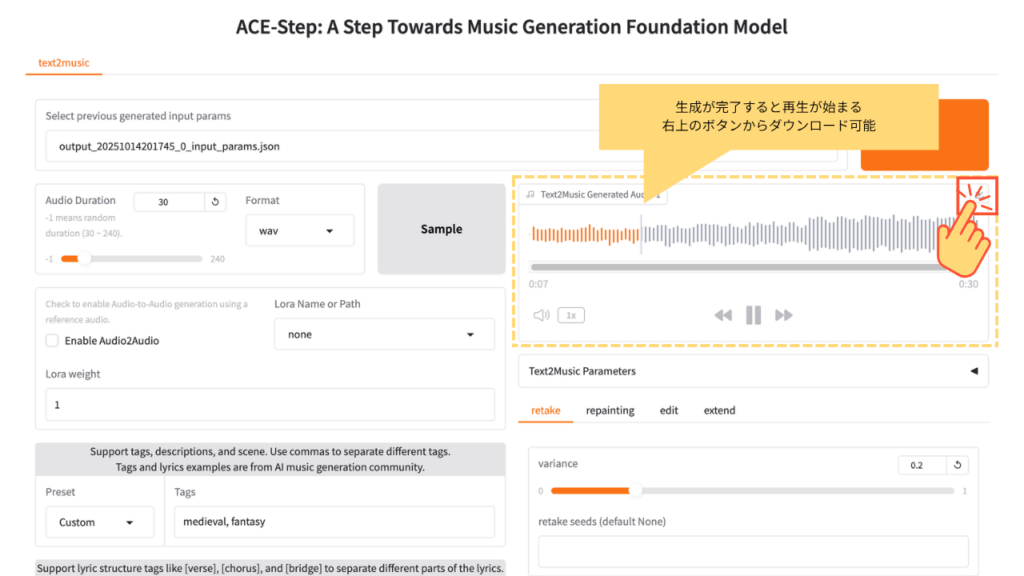

プロンプトで音楽を生成する(プロンプト例)

テキスト欄に「medieval, fantasy」など、曲のイメージを英語で入力し、「Generate」をクリックします。数十秒で音楽が生成されます。

生成後、波形と再生ボタンが表示され、AIが作った音をその場で試聴できます。

「Download」ボタンから output.wav を保存することも可能です。

注意事項(Gradio利用時のコツ)

- 長時間の利用でブラウザメモリが増加し、応答が遅くなることがあります。

- 生成中はタブを閉じずに待機してください。

- 音声ファイルは一時保存のため、必要なものは手動でバックアップを。

- UIが応答しない場合は、ターミナルで

Ctrl + Cを押して再起動できます。

ACE-Stepの使い方|CLIで曲を生成(上級者向け)

CLIで一括生成・自動化する(上級者向け)

コマンド操作でも同様に音楽を生成できます。以下のコマンドを実行します。

python infer.py --text "calm ambient piano and soft rain" --duration 15出力された output.wav を再生すれば、生成結果を確認できます。

CLIモードはバッチ処理や自動化スクリプトに向いています。

これでACE-Stepの基本動作をすべて確認できました。次章では、生成音の品質や出力傾向を見ていきます。

快適に利用するためには、メモリ8GB以上・GPU搭載環境を推奨します。

生成パラメータの主な項目(–text / –duration / –seed)

引数を変えることで、生成される音の長さや雰囲気をコントロールできます。

| –text | 生成する音楽の説明(英語推奨) |

| –duration | 出力の長さ(秒) |

| –seed | 再現性を保つ乱数シード(任意) |

例:30秒のアップテンポ曲を生成する場合

python infer.py --text "energetic electronic dance music" --duration 30これでACE-Stepの基本操作は完了です。次章では、生成された音源の特徴と出力結果を確認します。

生成結果と出力サンプル(音源あり)

ACE-Step は、音質の自然さとローカル実行の安定性を両立したAI音楽生成モデルです。ここでは、実際の生成結果の傾向と、他の代表的なモデルとの比較を整理します。

サンプル音源(Lo-Fi / Medieval・30秒・Instrumental)

シンプルな英単語で、長さは30秒指定で生成しました。

Windows環境で1曲7分程度で生成が完了しました。(i9-13900F/CUDAあり RTX4070 VRAM 12GB)

- 再生ボタンで即試聴

- wav/mp3/ogg/flac形式が選べる

タグでプロンプトを指定する形式で、本来はより多くのタグを与えたほうが質が上がるようです。

サンプル #01:Lo-Fi / study(30秒 / instrumental)

“Lo-Fi, study”で生成したサンプルです。[instrumental]を指定しています。

サンプル #02:Medieval / fantasy(30秒 / instrumental)

“Medieval, fantasy”(中世ファンタジー)で生成したサンプルです。[instrumental]を指定しています。

本記事内の音源サンプルはデモンストレーション目的でのみ掲載しています。

音質と生成傾向|長尺時の注意点

ACE-Step は、論文およびモデル説明の中で、拡散生成(Diffusion)を基盤に DCAE(Deep Compression AutoEncoder)と軽量 Transformer を統合した設計が採用されていると述べられています。

この構成は、メロディやリズム構造の一貫性(musical coherence)を保ちながら、従来モデルに比べて音響的なディテールをより多く保持できるとされています。

参考:ACE-Step 論文(arXiv.org)

実際の利用者からは、MusicGen系モデルで見られるようなパーカッションの不自然な途切れやテンポの歪みが少ないという報告が複数あります。

一方で、「やや圧縮感がある」「全体の音場に違和感が残る」といった声もあり、生成条件(プロンプト・シード・GPU性能)によって品質が変動する傾向が指摘されています。

参考:Reddit: ACE-Step discussion thread /

GitHub Issue #121(Audio output quality)

Gradio UIでは最大 240秒(約4分) までの出力設定が可能です。

長尺生成は技術的には実現していますが、構造的な整合性(long-range coherence)は依然として課題とされており、実用的な品質を保てるのは1分前後までが目安といえます。

参考:Hugging Face モデルカード

総じて、ACE-Stepは従来のMusicGen系モデルに比べて破綻の少ない安定した音響構造を持ちながらも、「人が聴いたときの違和感」や「空間の不自然さ」といった課題が残る──という評価でおおむね一致しています。

歌詞入力(Lyric2Vocal)とテキスト理解の対応言語

ACE-Step の公式サイトでは、歌詞を入力して生成された例が「Prompt Lyrics ACE-Step generated 01:00 / 04:00」として掲載されており、歌詞入力機能が実際に利用できることが確認されています。

(例:音楽全体で4分まで出力可能な設定の中で、1分部分に歌詞を反映したデモ)

参考:ACE-Step 公式ページ

モデル説明および ComfyUI ドキュメントによると、歌詞入力(lyrics)フィールドでは、[verse]、[chorus]、[bridge] といった構造タグを扱うことが可能とされています。

参考:ComfyUI ACE-Step チュートリアル(docs.comfy.org)

さらに、ComfyUI には Lyrics Language Switch 機能があり、日本語やカタカナで入力された歌詞を内部的に英語表記へ変換して処理するノードが試験的に提供されています。

ただし、変換精度や音声合成との同期にはばらつきがあり、現状では実験的な機能とされています。

参考:ComfyUI Wiki(日本語版)

したがって、歌詞入力は公式にサポートされており、日本語の短文やカタカナ詞を試すことも可能です。ただし、歌詞とメロディの整合性、および日本語処理の自然さについては、今後の改善が期待される段階です。

Suno・MusicGenとの比較|出力長・歌詞入力・ライセンス

主要ポイント(実行環境・最大出力長・歌詞入力・商用利用)で ACE-Step / Suno / MusicGen を比較します。各項目は一次情報へのリンク付きです。

| 項目 | ACE-Step | Suno | MusicGen |

|---|---|---|---|

| 実行環境 | ローカル(オフライン可) 公式:ACE-Step Project Page | クラウド専用(Webアプリ) 公式:Suno | 主にWeb/API/ローカル推奨環境あり(研究用途) Docs:MusicGen Docs |

| 最大出力長 | UIで最大240秒(約4分) モデルカード:ACE-Step v1-3.5B | モデルにより最大4分(v3.5/ v4) ヘルプ:How long will my song be? | 設計上約30秒が上限(位置埋め込み制約) Docs:MusicGen Docs |

| 歌詞入力 | 対応(lyricsフィールド・構造タグ) Docs:ComfyUI ACE-Step / 公式デモ:Prompt Lyrics例 | 対応(Customモードで歌詞入力) ヘルプ:Create Music with Text | 基本は非対応(テキストtoミュージックで歌詞生成機能は想定外) |

| 商用利用 | 可(Apache 2.0) リポジトリ:LICENSE | 可(有料プラン:Pro/Premier)/ 無料は非商用 ヘルプ:Commercial vs Non-commercial / ガイドライン:Community Guidelines | 不可(モデル重みは CC-BY-NC 4.0) HFディスカッション:License thread |

補足:Sunoは最新モデルで初回生成から最大4分が可能になりました(プラン・モデルに依存)。

参考:Suno Durationヘルプ

制限と改善余地|長尺・品質・環境要件

ACE-Step は開発段階のオープンソースモデルであり、音楽生成AIとしての完成度は高い一方で、いくつかの制約と改善の余地が残されています。

- 長尺生成の限界: Gradio UIでは最大240秒(約4分)の生成設定が可能ですが、90秒を超えると構造の破綻やリズムの揺れが発生しやすいとされています。これは論文でも「long-range coherence(長距離整合性)」が課題として明記されています。

参考:ACE-Step 論文(arXiv.org) - ボーカル生成: 歌詞→ボーカル(Lyric2Vocal)に対応しており、歌唱の生成が可能です。ただし自然さや歌詞整合はプロンプト・シード・環境に依存し、区間によって不安定さが出る報告もあります。

参考:ACE-Step 公式(Lyric2Vocal) / Reddit報告(ボーカル品質のばらつき) - プロンプト依存性: テキスト指示が曖昧な場合、同じフレーズの繰り返しや単調なループが発生しやすく、生成の多様性はプロンプト設計に大きく依存します。

- UI動作と環境負荷: Gradio UI使用時にはGPUメモリ使用量が増加し、大きなモデル(3.5Bパラメータ版)では安定動作にVRAM 8GB以上が推奨されています。

参考:Hugging Face モデルカード

これらの制約を踏まえると、ACE-Stepは依然として研究的・実験的な性格を持つモデルといえます。しかし、ローカル実行・歌詞条件入力・長尺試行といった特徴は、次世代の音楽AIに向けた重要なステップでもあります。

現時点では、安定したBGM生成に最も適しており、短尺・無伴奏素材の生成では非常に高い再現性を示します。今後、歌唱表現や長尺構造の進化が期待されます。

次章では、この出力特性を踏まえ、実際の活用シーンや応用例を見ていきます。

活用アイデアと注意点|商用利用のヒント

特徴まとめ(ローカル実行/歌詞条件/最大240秒)

| 項目 | 内容 |

|---|---|

| モデル構成 | Diffusion + DCAE + 軽量Transformer のハイブリッド構成(詳細:ACE-Step論文) |

| 入出力 | テキストプロンプト(tags / lyrics)または音声入力による変換生成 |

| ライセンス | Apache 2.0(商用利用可) |

| 拡張性 | LoRA学習・追加トレーニングによるスタイル調整が可能 |

| 最大出力長 | Gradio UI上で最大240秒(約4分)まで設定可(品質は1分前後が安定) |

これらの要素により、ACE-Stepは「ローカル実行 × 歌詞条件入力 × 長尺試行」という新しい生成スタイルを実現しています。

使いどころ(BGM向き)と注意点(ボーカルは条件依存)

- 長尺生成(1分超)では品質が不安定:構造破綻・リズム揺れのリスクあり。

- ボーカル生成に対応:歌詞→ボーカル(Lyric2Vocal)が可能。自然さや発音の滑らかさは条件依存のため、プロンプト調整や軽いポストプロセス(EQ/コンプ等)を推奨。

- 英語中心のプロンプト設計:日本語の短文にも反応するが、英語タグが安定。

ACE-Stepはまだ進化の途中にあるモデルですが、BGMや環境音の自動生成にはすでに実用的です。特に、ネット接続が不要な完全ローカルAI作曲環境としての価値は大きいでしょう。

まとめ|次の一歩(タグ設計と歌詞精度を高める)

ACE-Step は、「自分のPCで動かせる実用的な作曲AI」です。

草分け的なRiffusionは現在は動かすのは難しく、MusicGen系も実験的なレベル。

ローカルで動き、無料で、改造も可能──その自由度の高さは、AI音楽の“第三の波”とも呼べるかもしれません。

FAQ(よくある質問)

Q1. GPUなし(CPUのみ)でも動きますか?

はい、動作しますが生成に時間がかかります。まずは30〜60秒の短尺で試すのがおすすめです。

Q2. 推奨VRAMは?

3.5Bモデルは8GB以上が目安です。足りない場合は他アプリを閉じるか、解像度/長さを短くしてください。

Q3. 240秒で破綻しやすいのはなぜ?

長距離整合性(long-range coherence)の限界があるためです。60秒×複数生成→DAWで連結が実用的です。

Q4. 歌詞がうまくハマりません。

短句+テンポ語(例:slow/fast)を加え、--seedを固定。英語タグを基本に、必要に応じて日本語は短文で試してください。

Q5. 商用利用は可能?

ACE-StepはApache-2.0で配布されています(商用可)。ただしサンプル素材や外部データのライセンスは別途ご確認ください。

-120x68.png)