導入:ローカルAIで開発効率を高める

クラウドに頼らず、手元のマシンで大規模言語モデル(LLM)を動かせる環境として注目されているのが Ollama です。

本記事では、このOllamaを Visual Studio Code(VS Code) から拡張機能を利用して呼び出して使う方法を紹介します。

VS Codeの拡張機能を使えば、チャット、コード補完、リファクタ提案などをエディタ内で完結できます。

インターネット接続なしで動作するため、プライバシーや速度面でも優れています。

なお現在はGithub CopilotとMCPを利用した接続も可能となり、今後の主流となる可能背があります。

ToDo:MCP記事作成後に内部リンク

事前準備と環境要件

対応環境

- macOS / Windows / Linux(いずれも64bit)

- メモリ16GB以上推奨(モデルによる)

- GPU対応モデルではVRAM 8GB以上が望ましい

- インストール手順概要

インストールの手順は別記事「Ollamaのインストール方法」にまとめています。

おすすめモデル(2025年最新版)

VSCodeでの開発補助に向いた、Ollama対応のおすすめモデルを紹介します。

まずは軽量モデルから試し、環境に合わせて精度を求める構成に切り替えていきましょう。

インストールにはモデル名を指定する必要があります。公式サイトの一覧から調べられます。

👉 https://ollama.com/library

同系モデルの重複を避けるため、Llama 系は代表として 8B のみ掲載しています。

以下は用途別に分けたおすすめモデル一覧です。

最新・高精度モデル(推奨)

| モデル名 | 用途・特徴 | 推奨環境 |

|---|---|---|

| Qwen 3 7B / 30B | 最新世代。英日対応の精度が高く、最大 256K コンテキストに対応。 | ミドル〜ハイスペック GPU 環境 |

| Gemma 3 2B / 7B | Google 製の軽量多用途。マルチモーダル(画像+テキスト)対応。 | メモリ16GB以上/GPU推奨 |

| DeepSeek‑R1 7B | 高速・省リソースの汎用対話。ローカル常用に向く。 | CPU 環境でも可 |

実績のあるモデル(旧世代を含む)

| モデル名 | 用途・特徴 | 推奨環境 |

|---|---|---|

| Code Llama | コード生成に特化。VSCodeとの相性が良く、主要言語の補完に強い。 | メモリ16GB以上/GPU推奨 |

| Stable Code 3B | 軽量・高速で CPU でも実用的。小規模環境の入口に最適。 | メモリ8〜16GB程度/GPU不要 |

| Llama 3 8B(代表) | 多用途(チャット・要約・生成)。実績があり安定。 | ミドルスペック以上/GPUあると快適 |

モデルのインストール手順

代表的なモデルをインストールするには、以下のようにコマンドを実行します。

ollama pull deepseek-r1:7bこの DeepSeek-R1 モデルは日本語入力にも対応しており、チャットやコード補完の両方で使用できます。

いずれも数GB規模のダウンロードが発生するため、初回はネットワーク環境に注意してください。

現在インストール済みのモデル一覧を確認するには:

ollama list既存モデルを最新バージョンに更新する場合は:

ollama update <model-name>準備が整ったら、Ollamaをサーバーとして起動しておきます。

ollama serveOllama公式ドキュメント:https://ollama.com/docs

VSCode側の設定

VS CodeからOllamaに接続する方法はいくつかありますが、本記事では実績のある拡張機能”Continue”を利用する方法を紹介します。

Continue公式ドキュメント:https://docs.continue.dev/providers/ollama

1. VS Codeを準備

下記の説明では、VSCodeがインストールされていることを前提としています。

本記事では直接利用しませんが、MCPに対応したバージョンである1.102以降を推奨します。

VSCode Marketplace – Continue拡張ページ:

https://marketplace.visualstudio.com/items?itemName=Continue.continue

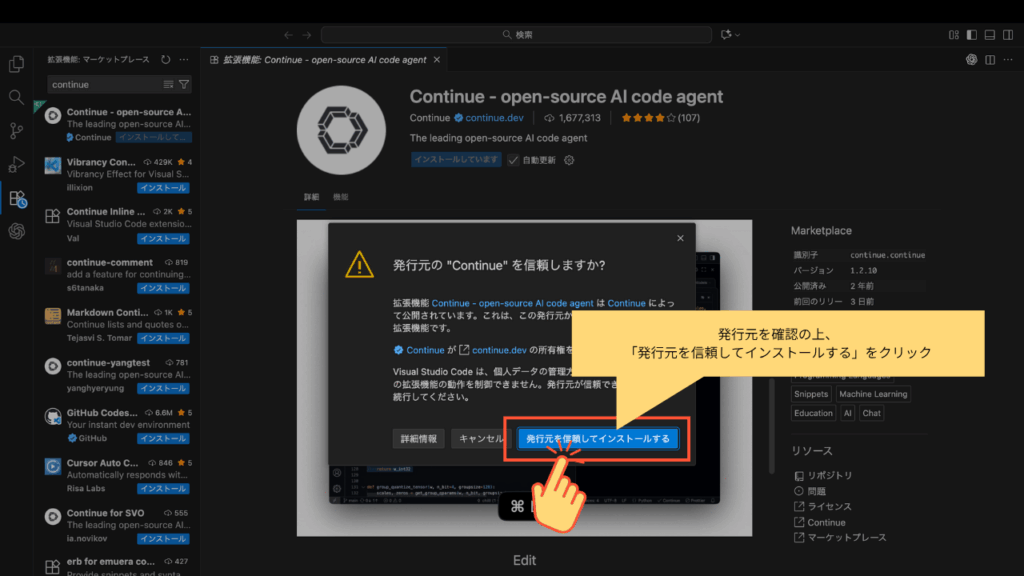

2. 拡張機能Continueをインストール

- 検索バーで「Continue」を検索し、「インストール」ボタンを押します。

- 発行元に関する確認が入る場合は、内容に問題ないことを確認し「発行元を信頼してインストール」をクリックする。

VSCode Marketplace – Continue拡張ページ:

https://marketplace.visualstudio.com/items?itemName=Continue.continue

3. 接続設定

Ollamaがサーバーとして起動していれば、VSCodeに特別な設定は不要です。

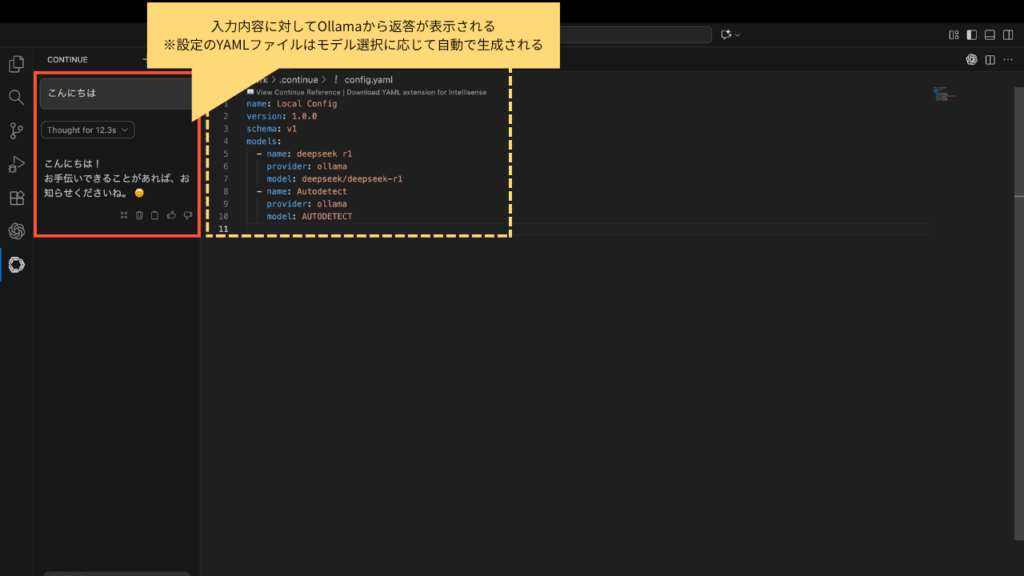

拡張機能が有効になると、VS Code上にContinueのウィンドウが現れます。

ここでOllamaと予めインストールしたモデルを選択します。

デフォルトではOllamaやVSCodeに特別な設定は不要ですが、独自の設定を行った場合はconfig.yaml等の調整を行います。

これでOllamaと同様にチャットが可能で、生成AIによるコードの補間や相談などができるようになります。

下記は「Continueという拡張機能でできることを教えて」と問いかけた際の回答のサンプルです。コピーするとMarkdown形式となります。

モデルはDeepSeekR1:8Bを利用しており、回答はChatGPTのファクトチェックによると概ね正確です。ただ、黄色マーカー部分は「誤りまたは説明が不十分・曖昧な点」と指摘があった点です。Github Copilotと説明が混同しているようにも見受けられます。サンプルとしてそのまま掲載しておりますので、ご注意ください。

Cotinue は、ユーザーの質問や指示に答えるために設計された AI ツールです。以下に、その主な機能と特徴を説明します。

---

### **Cotinue でできること**

1. **質問に答えたり、説明を生成したりする**

- 例えば、「JavaScript で関数を作成する方法を教えて」とか、「React と Vue の違いを説明して」といった質問にもお答えします。

2. **コード生成と修正**

- 指定されたプログラミング言語でコードを生成したり、既存のコードを修正したりします。

- 例えば、「Python で素数を計算する関数を作成して」とか、「このコードを TypeScript に変換して」といった指示にも対応します。

3. **ファイル操作のサポート**

- ファイルの読み込み、新規作成、編集、削除などの操作を手伝います。

- 例えば、「src/app.js を修正して」とか、「新しいファイルを作成して」といった指示にも対応します。

4. **情報の検索**

- ユーザーの質問に応じて、関連する情報(Web 上の知識、ドキュメント、コード例など)を検索します。

5. **ツールの操作**

- 多くのプログラミングツールやコマンドラインの操作を支援します。

- 例えば、「git commit を実行する」とか、「Python の virtualenv を作成する」といったタスクも手伝います。

6. **多言語対応**

- 多くの言語(日本語、英語、中国語など)に対応しており、ユーザーの言語で返答します。

---

### **Cotinue の特徴**

- **リアルタイムで対応**:質問や指示を受けてすぐに反応します。

- **ファイル操作のサポート**:ユーザーがファイル操作を指示した場合、Cotinue はその操作を実行できます。

- **エラーチェック**:生成したコードには、可能なエラーをチェックし、修正案を提案します。

---

### **Cotinue ができないこと**

- **外部のファイルへの直接アクセス**:ユーザーの環境にあるファイルを直接操作することはできません。代わりに、ユーザーの指示に基づいて、シミュレートや提案を行います。

- **セキュリティ制限**:危険なコードや外部からのファイル実行は行いません。

- **リアルタイムのデータ取得**:最新のデータ(例えば、株価や天気)は提供できませんが、一般的な知識は持っています。

---

### **例: 使い方**

- **コード生成**

> 「Python で、3 つの数字の平均を計算する関数を作成して。」

> → コードを生成し、ユーザーに提案します。

- **ファイル編集**

> 「src/app.js を修正して、ボタンをクリックするとアラートが表示されるようにして。」

> → ファイルの修正を提案し、ユーザーに確認を求める場合もあります。

---

### **注意事項**

- Cotinue は AI なので、誤った情報を生成することがあります。ユーザーは生成内容を必ず確認してください。

- 特定の環境(OS、言語、ツールのバージョンなど)に依存した操作は、環境が不明な場合はサポートできません。

---

お役に立てることでお手伝いしましょう!何か具体的なことをお知りになりたいですか? 😊補足:MCPとの関係について

Visual Studio Code は Model Context Protocol(MCP)をサポートしていますが、Ollama は現時点で MCP サーバーとしての公式対応を行っていません。

そのため、この接続は MCP 経由ではなく、HTTP ベースのREST APIをローカルで呼び出す形で行われます。

簡単な使い方とワークフロー

コード補間

- エディタでコードを入れたい場所で”⌘+I”を押し、「helloと出力して」等の指示を出すとコードや関数を保管してくれます。

チャット形式での利用

- エディタで聞きたい箇所を選択し、”⌘+L”を押すとチャット欄に選択箇所がコピーされます。

「このコードの意味を教えて」など質問ができます。 - カレントファイルへのアクセス許可を求められる場合などがあります。メッセージは英語ですが、わからない場合は翻訳を依頼しても良いでしょう。

トラブルシューティング

| 症状 | 対処法 |

|---|---|

| VS CodeがOllamaに接続できない | Ollamaサーバーが起動しているか確認(ollama serve) |

| モデルが見つからない | ollama pull で再取得 |

| 補完が出ない | 拡張機能を再読み込み or 設定ファイル確認 |

FAQ

Q1. Ollamaは無料で使えますか?

はい。基本機能は無料で利用可能です。商用利用の場合はモデルのライセンスを確認しましょう。

Q2. GPUがなくても動作しますか?

はい。CPUでも動作しますが、生成速度は遅くなります。

Q3. OpenAI APIとの違いは?

Ollamaはローカル実行のため通信不要。API課金もありません。

Q4. VS Codeとの接続はどの拡張機能を使うのがベスト?

現在、VS CodeはGithub Copiloを備えており、有料でも構わない場合はそちらの利用をおすすめします。Ollamaにこだわりがあり、シンプルに使いたい場合は、現状は「Continue」がおすすめです。Github CopilotとMCPブリッジを利用すればOllamaを接続して利用可能ですがやや複雑です。今後、Ollamaが公式にMCPに対応する場合は、そちらの利用を推奨します。

Q5. モデルはどこに保存されますか?

デフォルトで ~/.ollama/models にキャッシュされます。

まとめ

VS CodeとOllamaの連携により、「ローカルで動くAI開発環境」 を誰でも簡単に構築できます。

高速・安全・低コストなAIコーディングの第一歩として、ぜひ試してみてください。