LM Studioは、Windows・macOS・Linuxで動くローカルLLM用のデスクトップアプリで、GUIからモデルの検索・ダウンロード・チャット・APIサーバー起動までをまとめて扱えるツールです。 LM Studio

ここではMac(Appleシリコン)での画面をベースに説明しますが、WindowsやLinuxでもダウンロード元や流れはほぼ同じです。細かいUIはバージョンで変わる可能性があるため、必要に応じて公式ドキュメントも参照してください。

LM Studioとは

LM Studioは、Element Labs社が提供する「ローカルLLMの統合クライアント」です。 ChatGPTなどブラウザ経由のクラウドサービスではなくネイティブアプリとして動作し、次のような機能をまとめて提供します。

- モデルを検索・ダウンロードしてローカル保存する機能。

- チャット画面から、選んだモデルとすぐに対話できる機能。

- APIサーバーとして動作させ、他のアプリからローカルLLMを利用できる機能。

似たツールとしてOllamaなどがありますが、LM StudioはGUI中心でわかりやすく、モデルカタログも見やすいのが特徴です。CLIベースよりも、まず「触って感覚をつかみたい」人に向いています。

事前に確認しておきたいスペック

LM Studio自身は動作する環境をほぼ選びませんが、モデルによっては要求スペックが高くなります。

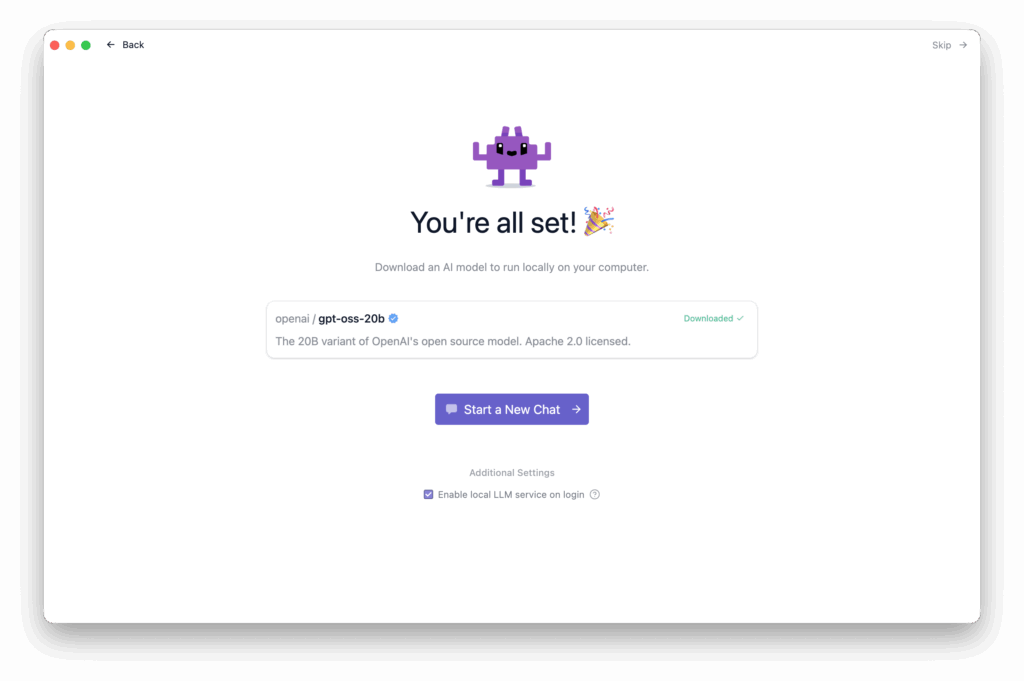

本記事公開のタイミングでは、LM Studioインストール時にgpt-oss-20bを提案されました。

gpt-oss-20bは、OpenAIが公開したオープンウェイトモデルで、約21BパラメータのMixture-of-Experts構成ながら、16GBメモリ程度で動作することを前提に設計された推論モデルです。ベンチマークではo3-miniと同等レベルの性能を狙った位置づけとされています。 OpenAI Platform

gpt-oss-20bは、OpenAIの説明では16GBメモリでの動作を想定したMXFP4量子化モデルとして設計されています。

Macの場合、次のような構成であれば、まず試す価値があります。

Appleシリコン(M2 / M3世代)で、ユニファイドメモリ16GB以上。

ストレージに空きが数十GBあること(gpt-oss-20b本体で10GB超を消費します)。

Macbook Air M2でも何とか動きますが、実用性はありません。速度的に実用は厳しいものの、。

8GBメモリのMacでも起動自体はできる可能性がありますが、生成速度の低下やメモリ不足で不安定になるリスクが高くなります。この記事では、16GB以上を前提条件として説明します。

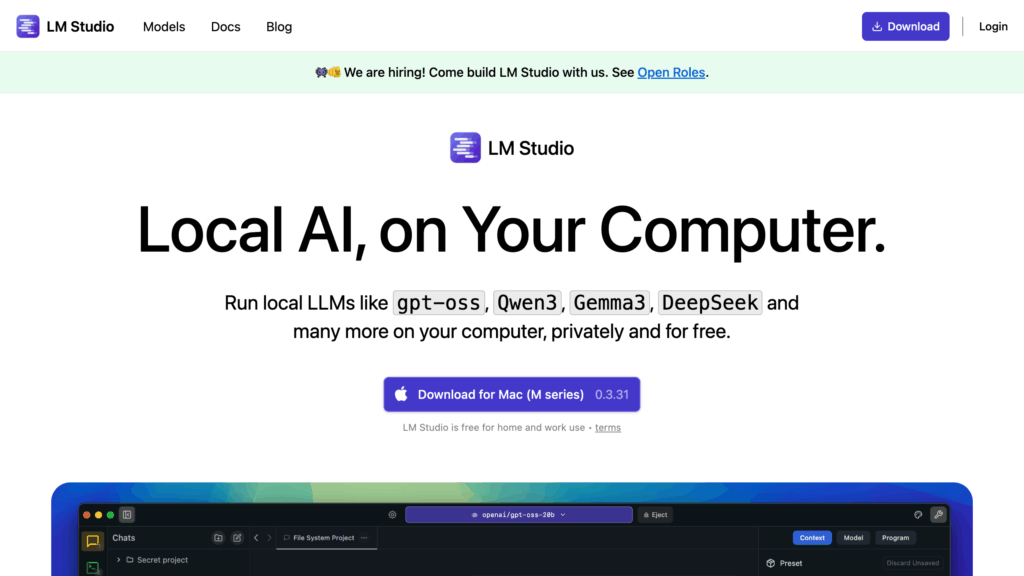

LM Studioを公式サイトからダウンロードする

まず、公式サイトからアプリ本体を入手します。

ブラウザで LM Studio – Local AI on your computer のダウンロードページを開きます。

LM Studio – Local AI on your computer

ページ中央付近にある「Download for macOS」のボタンから、Appleシリコン向けのdmgファイルをダウンロードします。

入手したファイルは、たとえば次のような名前になっています。

LM-Studio-0.3.31-7-arm64.dmg

バージョン番号は更新されるため、実際のファイル名は環境によって異なります。

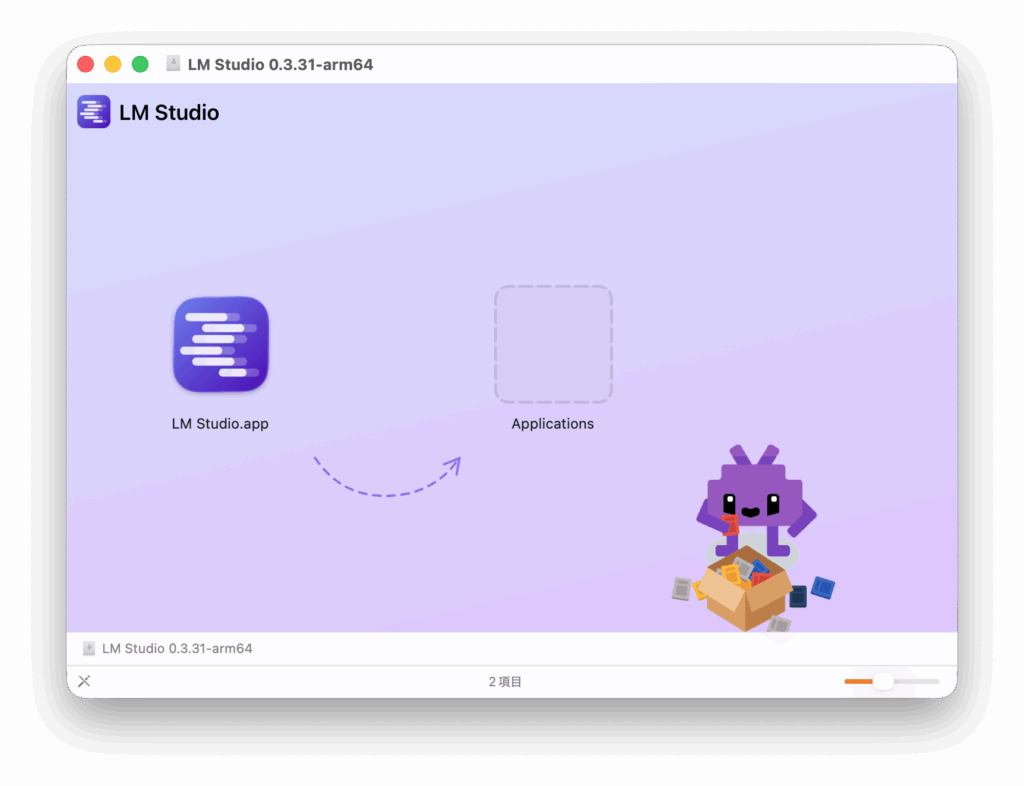

Macへのインストール手順

ダウンロードが完了したら、Finderでdmgファイルをダブルクリックしてマウントします。

マウントすると、LM Studioのアイコンと「Applications」フォルダが表示されます。

画面に表示されている LM Studio.app をApplicationsフォルダにドラッグ&ドロップ します。

これでインストールは完了です。

インストール後は、マウントしたdmgをイジェクトし、ダウンロードしたdmgファイル自体は削除しても問題ありません。アプリ本体は「アプリケーション」フォルダにコピーされているためです。

初回起動とセットアップ

インストールが完了したら、「アプリケーション」フォルダから LM Studio を起動します。

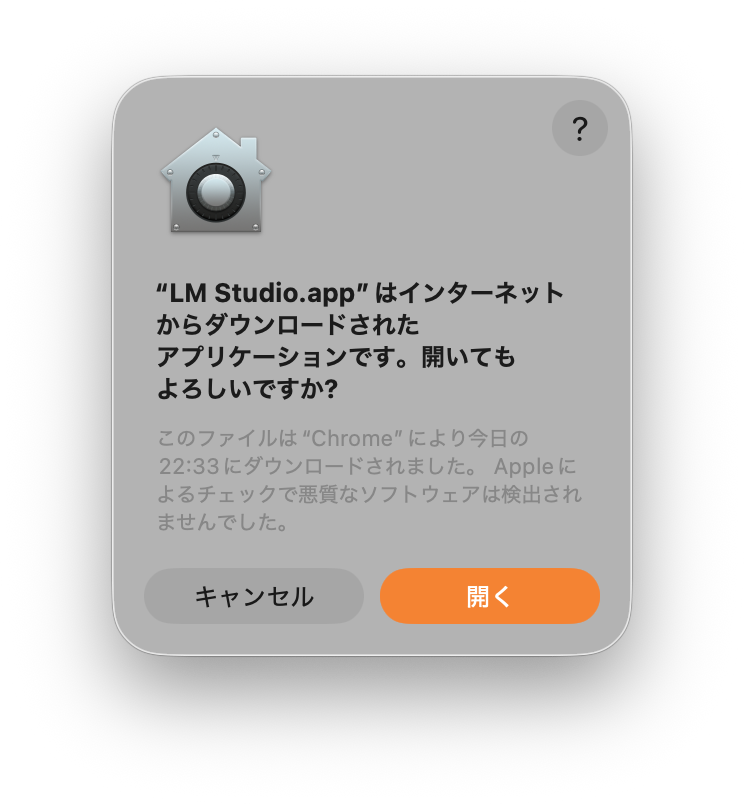

初回起動時は、インターネットからダウンロードしたアプリである旨の警告が表示されることがあります。その場合は、macOSの案内に従って開くことを許可してください。

起動すると、最初に Get Started 画面が表示されます。

ここでは初回の手順通りに進めますが、右上の”Skip”でメイン画面に飛ぶこともできます。

「Get Started」ボタンを押すとセットアップが始まります。もし設定をスキップしたい場合は「Skip」を選んでも構いませんが、ここでは一通り進めておくと全体像がつかみやすくなります。

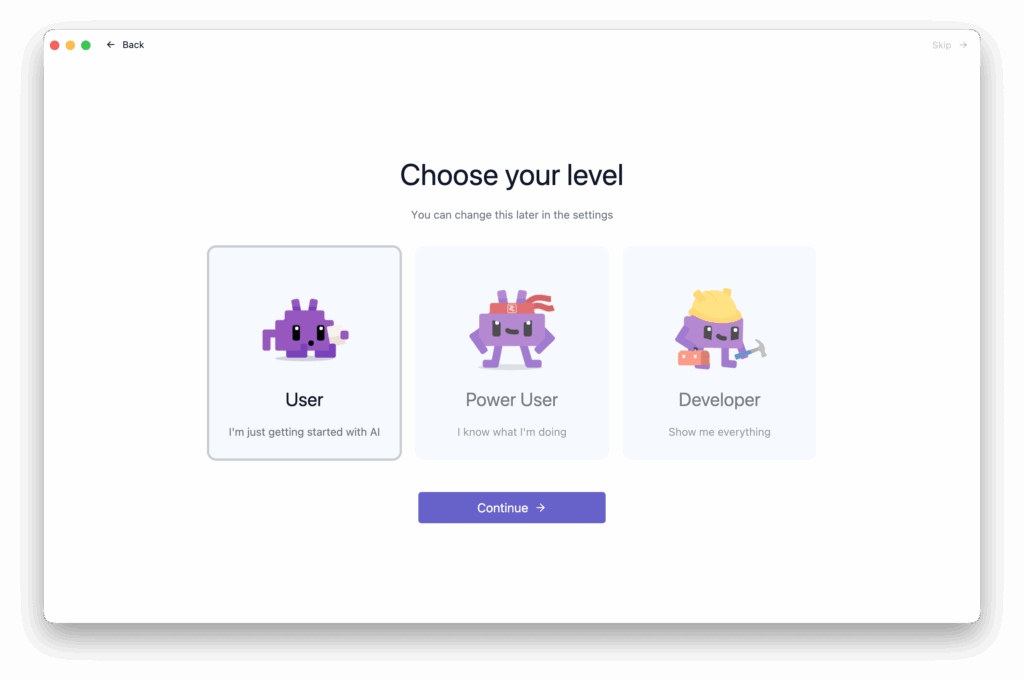

次に、ユーザーのレベルを選ぶ画面が表示されます。

ここでは User / Power User / Developer などの選択肢があり、選んだレベルによって表示されるメニューや説明の詳しさが変わります。

後から設定画面で変更できるので、迷った場合はもっともシンプルな User を選んでおけば問題ありません。

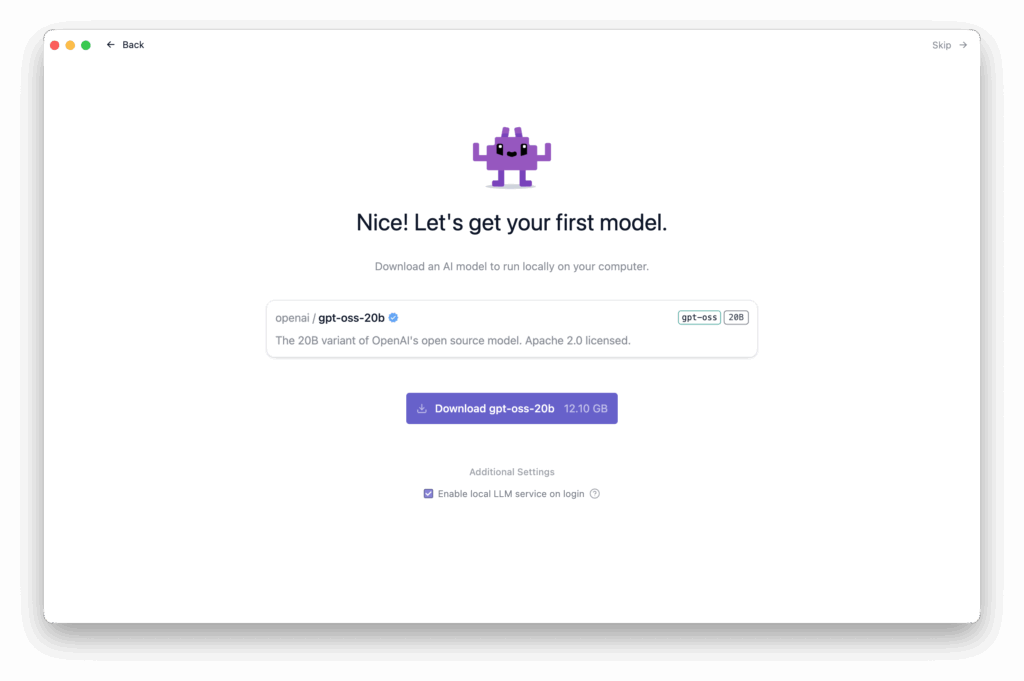

その後、初回セットアップの一環として「おすすめモデル」のダウンロードを提案されます。

ここで選んだモデルをそのまま使っても良いですし、スキップして後から自分で選び直すこともできます。

gpt-oss-20bをダウンロードしてみる

この記事では、案内に従って gpt-oss-20b をそのままダウンロードする流れを例にします。

gpt-oss-20bは、OpenAIが公開したオープンウェイトモデルで、Apache 2.0ライセンスと独自の利用規約に基づいて利用可能です。ベンチマークでは、OpenAIのo3-miniと同程度の性能を目標としており、ローカル推論やエッジ環境での利用を想定した「中型」モデルという位置づけです。

モデル選択画面でgpt-oss-20bが表示されている場合は、そのカードをクリックして詳細画面を開きます。

詳細画面には、モデルのサイズや必要メモリ、ライセンス情報などが表示されます。

gpt-oss-20bは、おおよそ 12GB前後 のディスク容量を消費します。SSDの空き容量には余裕を持たせておくと安心です。

画面右側の Download ボタンをクリックすると、モデルのダウンロードとインデックス作成が始まります。ダウンロード状況はプログレスバーと速度表示で確認できます。

回線速度やLM Studio側のミラーの混雑状況によって時間は変わります、約12数GBとファイルサイズは大きいため完了まで待ちましょう。ダウンロードが完了すると、チャットが開始できるジュビが完了します。

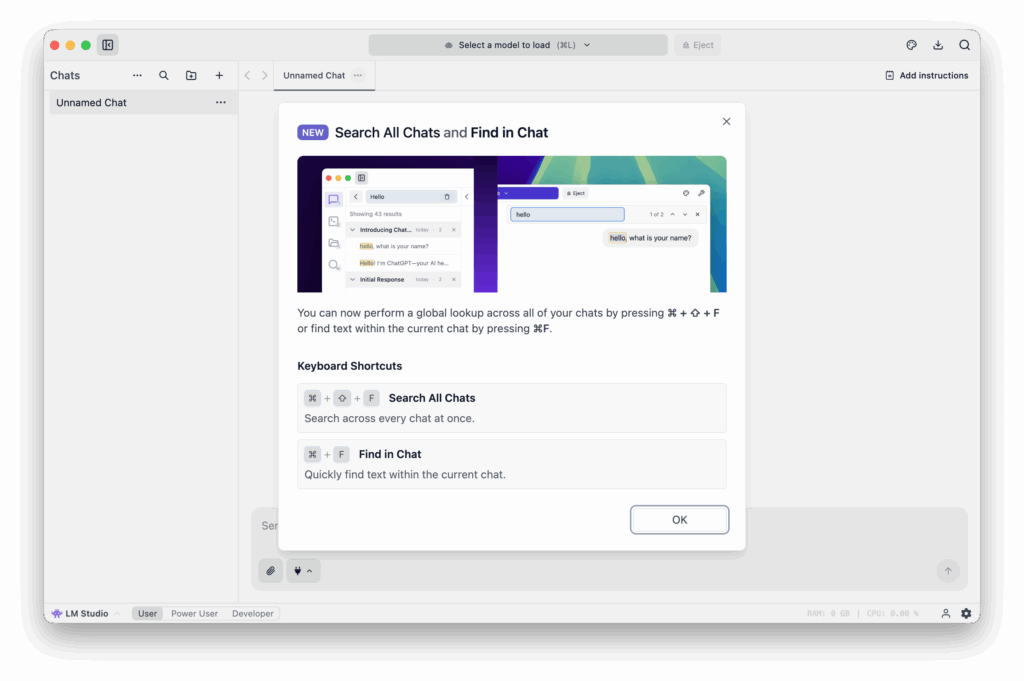

モデルをクリックするとチャット画面が開きます。

新機能などのTips表示が出る場合は、”OK”をクリックして閉じれば次の画面に進みます。

日本語で簡単なプロンプトを入力してみましょう。起動後の最初の会話は、モデルのロードで時間がかかる場合があります。レスポンスが返ってくれば、ローカルでの推論が正常に動作していることを確認できます。

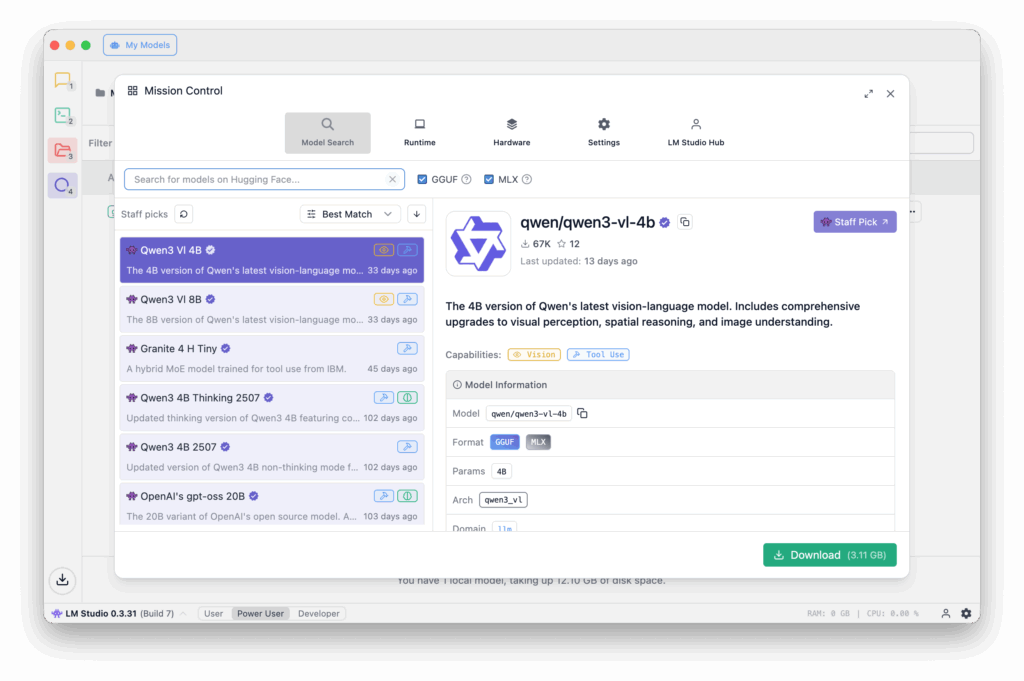

モデルの選び方の基本

gpt-oss-20bは性能面では魅力的ですが、メモリ消費とモデルサイズもそれなりに大きいモデルです。

LM Studioでは、同じgpt-ossでもパラメータ数が小さい派生モデルや、別系統の軽量モデル(Llama、Gemma、DeepSeekなど)も多数公開されています。 LM Studio

モデル選択画面は次のようなイメージです。

モデルを選ぶときの目安としては、次のように考えるとシンプルです。

まずは gpt-oss-20b のような「やや重いが高性能」なモデルを1つ入れて、ローカルLLMの性能ピークを体感する。

そのうえで、小さめのモデル(数Bクラス) も1〜2個入れておき、処理速度や精度の違いを比較する。

実際の用途が「メモ取り」「要約」「軽いチャット」程度であれば、小さめのモデルでも十分なケースが多く、応答速度と精度のバランスで最適な1本を選んでいくのがおすすめです。

LM Studioの良いところと注意点

LM Studioのメリットは、次のようなポイントに集約できます。

まず、インストールと初回セットアップが非常に分かりやすいことです。

また、モデルのダウンロードや切り替えもGUI上で完結するため、「どこからモデルを取ってくるのか」「設定ファイルをどこに置くのか」といった悩みがほとんどありません。パラメータ数や量子化のバリエーションの表示もわかりやすく、一覧性が良いのが特徴です。

次に、OpenAI互換APIサーバーとして動作させられる点です。これは別記事で詳しく扱いますが、LM Studioを起動しておけば、手元のMacを「自前のOpenAI互換エンドポイント」のように扱うことができます。Pythonスクリプトやノートアプリ、ブラウザ拡張などから接続すれば、クラウドAPIを一部置き換えられます。

モデルやLM Studio自体は頻繁にアップデートされるため、この記事の画面構成と細部が異なる可能性があります。新しいオプションやモデルが増えている場合は、必ず公式サイトとモデルカードを確認してください。

よくある質問(FAQ)

ここからは、この記事の範囲でよく出てきそうな疑問を簡単に整理します。

Q1. LM StudioとOllamaはどちらを選べばよいですか?

コマンドライン前提でも構わない、Dockerやサーバー運用に慣れている、という方はOllamaも有力です。一方、「まずはGUIでモデルを触ってみたい」「モデルカタログを眺めながら選びたい」という場合は、LM Studioのほうが導入のハードルが低くなります。どちらもローカルLLM環境として実績があるため、最終的には好みとワークフローで選んで問題ありません。

Q2. gpt-oss-20bは本当に無料で使えますか?

モデルの重み自体はOpenAIからApache 2.0ライセンスで公開されており、利用にはOpenAIのgpt-oss利用規約が適用されます。商用利用を含めて柔軟なライセンスですが、具体的な利用形態がライセンスに抵触しないかどうかは必ず原文を確認してください。この記事ではライセンス条文の細部までは扱いません。

Q3. どのくらいの速度が出れば「快適」と考えればよいですか?

体感の「快適さ」は用途によって変わりますが、チャット用途なら、1秒あたり数トークン以上出ていれば実用的な対話が成立しやすくなります。Macのスペックやバックグラウンドの負荷によって変動するため、まずは実際にgpt-oss-20bを動かし、許容できなければ小型モデルも併用する、という順序がおすすめです。

Q4. 設定を間違えてもやり直せますか?

ユーザーレベルやおすすめモデルの選択は、後から設定画面やモデル一覧で変更できます。最初はシンプルに、「User」レベル+おすすめモデル1つ+自分で選んだモデル1つ、くらいの軽い構成で始めて問題ありません。

まとめと次の一歩

この記事では、LM StudioをMacにインストールし、OpenAIのgpt-oss-20bをダウンロードして、ローカルでチャットできる状態にするまでを一本の流れで整理しました。

ポイントは次の3つです。

まず、LM StudioはローカルLLMをまとめて扱えるGUIクライアントであり、モデルの検索からチャット、APIサーバー化までを一つのアプリに収めていること。

そして、まずは1本の重めモデルで性能の上限を体感し、その後軽量モデルとの比較で自分のワークフローに合う構成を見つけていく、という進め方を容易にするデザインであることです。

また、開発者向けにもLM Studioの設定画面からOpenAI互換APIを有効化し、ローカルのエンドポイントとして他アプリから呼び出す運用を試すと、クラウドAPIとの違いや費用感が見えやすくなります。その内容は、別記事として「LM StudioをOpenAI互換APIとして使う手順」といった形で整理していく予定です。

モデルやLM Studio本体の仕様は今後も変化していくため、この記事をベースにしつつ、導入前には必ずLM Studio公式サイトとgpt-ossのモデルカードで最新情報を確認し、環境に合わせてアップデートしていただくことをおすすめします。