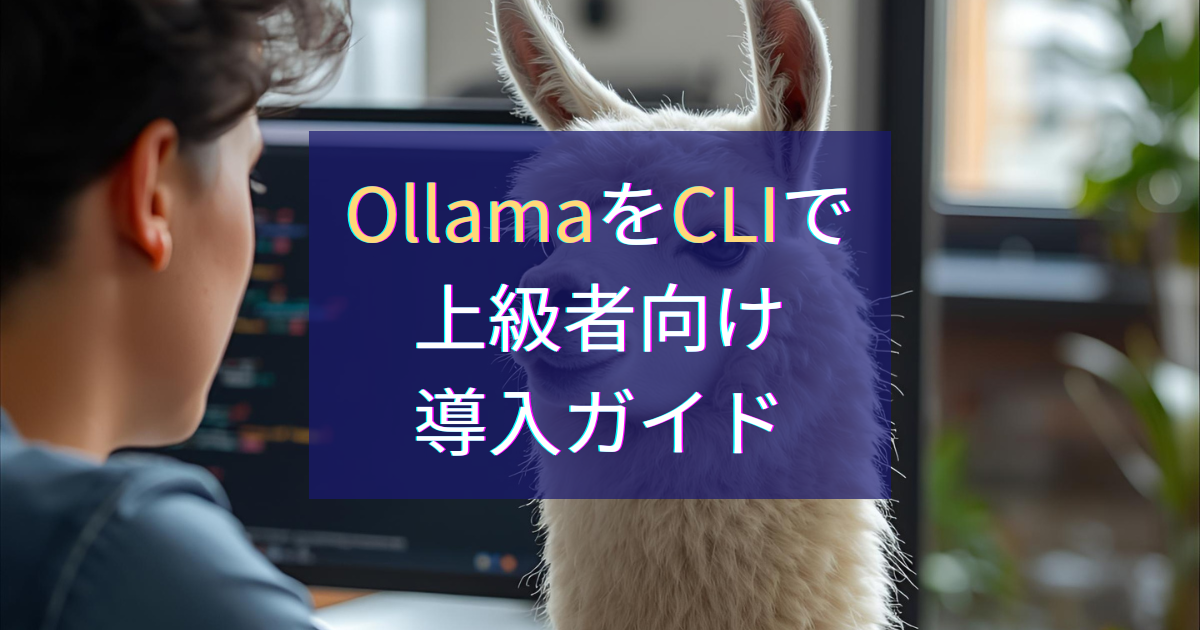

この記事のポイント(30秒で要点)

- OllamaをCLI(コマンドライン)で使う方法を解説。GUIでは触れられない高度な操作が可能

- インストール → 動作確認 → モデル実行までの最短手順を収録

- macOS/Linux/Windows(WSL)対応、モデルの取得・管理方法も解説

- 自動化・スクリプト連携など、上級者向けの実践ヒントを紹介

導入(背景と目的)

ローカルAIをより深く使いこなしたいなら、OllamaのCLI(コマンドラインインターフェース)は必須のツールです。

GUI版では隠れている機能をすべて引き出し、スクリプトや自動化と組み合わせて自由に操作できます。

この記事では、Ollama CLIの導入からモデル実行までを安全にガイドします。

動作環境と前提

- 対応OS:macOS / Linux / Windows(WSL対応)

- Ollama本体がインストール済みであること(GUI版も可)

- ネットワーク接続(初回モデル取得時のみ必要)

公式リンク:

CLI導入と基本コマンド

既にGUIアプリをインストール済みの場合はCLIも利用です。

インストール方法はこちらにまとめてあります。

補足) CLIからのインストール方法について

Linuxでは以下のコマンド実行でCLIからインストールが可能です。

curl -fsSL https://ollama.com/install.sh | shmacOSユーザー向けにはHomebrewでも導入可能です。

brew install ollamaただし、現時点ではOllama公式ドキュメントでは言及がなく、明示的にサポート・推奨されているわけではないようです。

macOSの場合は公式サイトから.dmgインストーラーをダウンロードしてインストールするのが推奨です。

2. 動作確認

以下を入力してバージョン情報を確認します。

ollama --versionバージョン番号が表示されれば成功です。

エラーが出る場合は環境変数 PATH にOllamaが追加されているか確認します。

3. モデルの取得と実行

CLIではモデルを自分で選び、実行できます。

まずモデルをダウンロードします。

ollama pull llama3その後、次のコマンドでAIモデルを起動します。

ollama run llama3🖼️ 図2:ターミナルで ollama run llama3 を実行した様子。入力欄に「こんにちは」と打つと、AIが即座に応答を返します。

チャットを終了する場合は Ctrl + C を押します。

4. モデルの管理

ローカルに保存されているモデルの一覧を表示:

ollama list不要なモデルを削除:

ollama rm llama3これでディスク容量を節約できます。

実行結果とサンプル応答

以下は、Ollama CLIを使った実行例です。

> ollama run llama3

>>> こんにちは、今日はどんな質問がありますか?ターミナル上でAIが応答すれば、ローカル環境で正常に動作しています。

応用例と活用のヒント

CLIを利用することで次のような応用が可能になります。

- スクリプトで自動的にAI応答を取得

Modelfileを使った初期設定・パラメータの制御- PythonやNode.jsなど他ツールとの連携

研究・開発・自動化など、より高度な用途に最適です。

FAQ(よくある質問)

Q1. CLIはGUIと何が違いますか?

CLIではモデルの取得・削除・パラメータ設定・スクリプト自動化など、GUIより細かな制御が可能です。

Q2. Homebrewでのインストールは安全ですか?

動作は確認されていますが、公式ドキュメントでの明記はありません。確実に行うなら公式サイトの.dmgインストーラーを推奨します。

Q3. Windowsで使えますか?

はい、WSL(Windows Subsystem for Linux)経由で利用可能です。Ollama公式もWindows対応を進めています。

Q4. モデルの削除で容量はどのくらい節約できますか?

モデルによりますが、1つあたり数GB以上の削減になる場合があります。不要モデルは定期的にollama rmで削除を推奨します。

Q5. 自動化の応用例を知りたい。ollama runをスクリプトに組み込み、ログ取得や定期タスク化することで、ローカルLLMを業務フローに統合できます。

まとめ:CLIで広がるローカルAIの可能性

Ollama CLIは、ローカルAIを自在に操りたい上級者にとって強力な選択肢です。

一度操作に慣れれば、モデルの切り替えや自動化が格段に効率化されます。

次は、Modelfile を活用した設定方法を紹介します。

[内部リンク:Modelfile活用ガイド]