はじめに:GitHub Copilotのbyok機能でOllamaとローカルで接続

Visual Studio Code(VSCode)のGitHub Copilot拡張機能には、byok(Bring Your Own Key)という仕組みがあり、外部のAIモデルやローカルLLMを利用できるようになっています。

この機能を使うことで、OllamaのローカルLLMをGitHub Copilotのチャット機能やコード補完で直接利用可能です。

なお、byokはMCP(Model Context Protocol)やOllamaのREST APIとは異なる仕組みです。MCPは複数のAIツールを統一的に扱う通信プロトコルで、過去にはMCPブリッジを使いOllamaを連携させる方法や、REST APIを使う拡張機能もありました。しかし現在では、GitHub CopilotのbyokによるOllama直接接続が最もシンプルで推奨される方法です。

byok(Bring Your Own Key)とは

「byok」とは “Bring Your Own Key” の略で、GitHub Copilot拡張機能が提供する仕組みです。

ユーザーが自分の環境で用意したAIモデルやローカルLLMをCopilotから利用できるようにする機能で、Ollama連携もこの仕組みを使って実現します。

設定は非常にシンプルで、Ollamaをデフォルト設定(http://localhost:11434)で起動していれば、追加設定なしで自動的に利用可能です。

補足:byokの設定変更が必要なケース

以下の場合は、VSCodeの設定でgithub.copilot.chat.byok.ollamaEndpointを指定します:

- Ollamaのポート番号を変更している場合

- 別のマシンで動作しているOllamaを利用する場合

設定例(settings.json):

{

"github.copilot.chat.byok.ollamaEndpoint": "http://localhost:11434"

}使い方:VSCodeでOllamaを利用する手順

ここでは、Ollama、VSCode、Github Copilotについては利用経験があり、インストールは完了しているものとして説明します。またOllamaではコーディング支援に適したモデルを予め準備しておくと便利です。

バックグラウンドでOllamaを起動します。デフォルトではhttp://localhost:11434で待機となります。

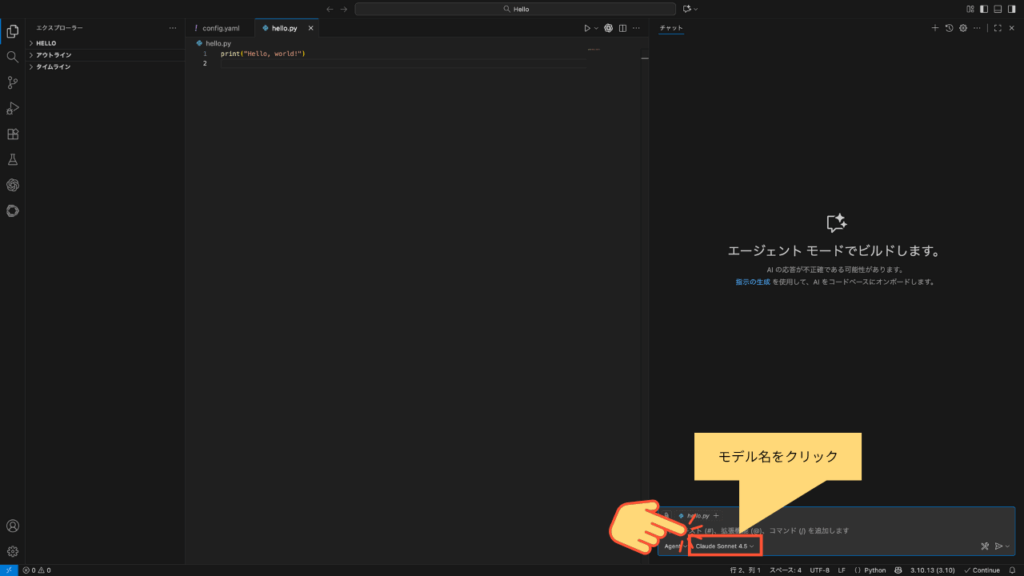

$ ollama serveVSCodeを起動し、チャット欄を開きます。チャット欄下のモデル名をクリックします。

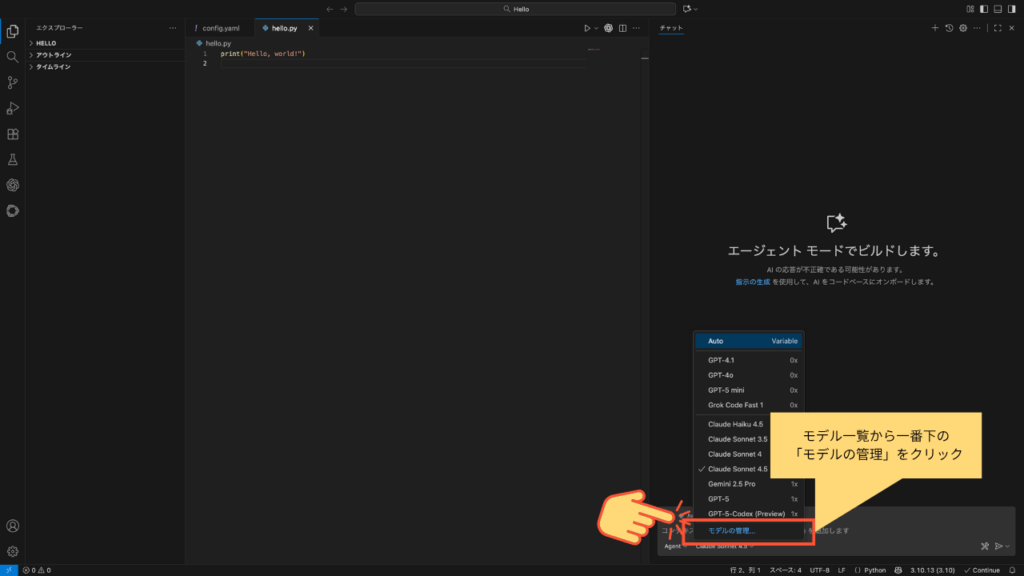

モデルの一覧表示から「モデルの管理」をクリックします。

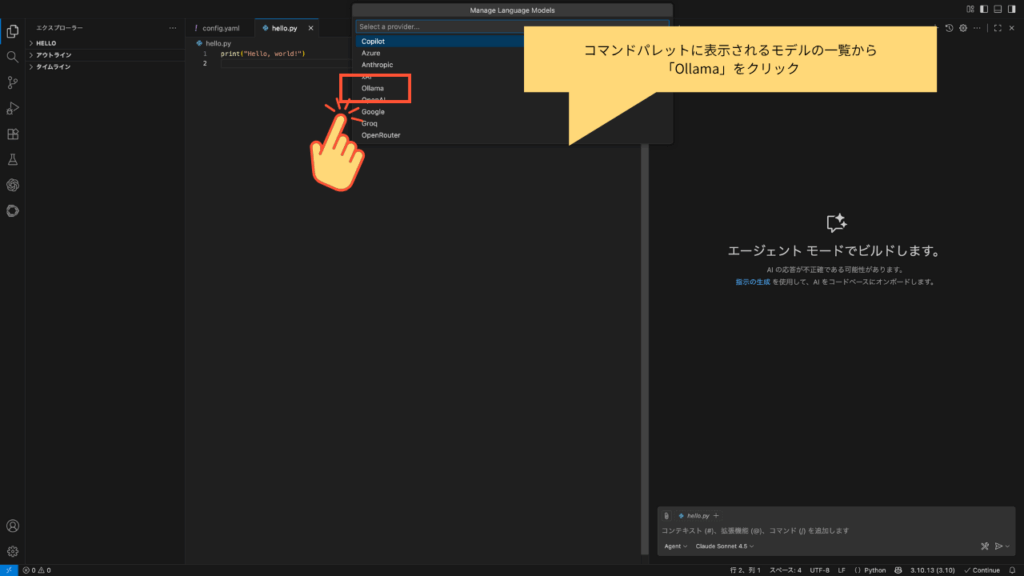

コマンドパレットに一覧が出るので、一覧から「Ollama」を選択します。

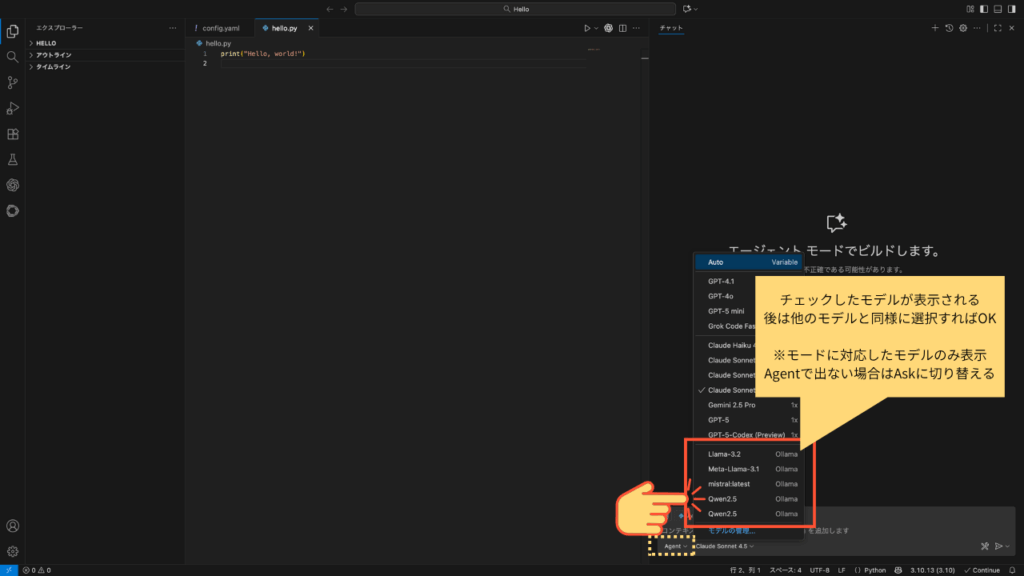

Ollamaに予め導入済みのモデルが表示されるので、使いたいモデルをチェックしOKを押します。

VSCodeのチャットパネルまたはコード補完でOllamaモデルを選択して利用となります。

これだけで、ローカルのOllamaモデルがGitHub Copilotから利用可能になります。

関連情報:Continue拡張機能について

GitHub Copilotのbyok機能以外にも、VSCodeでOllamaを利用するための拡張機能として「Continue」があります。

ContinueはOllamaとのローカルHTTP通信(REST API)を利用し、リポジトリ文脈の自動注入や差分適用、プロンプトテンプレートなどの機能を提供します。GitHub Copilotを使わない場合の選択肢として検討できます。

詳細は下記の記事や、公式ページ(https://continue.dev)をご参照ください。

参考:MCPブリッジを使う方法(非推奨)

過去には、OllamaのHTTP APIをMCP(Model Context Protocol)サーバー仕様に変換するNode.js製ツール「@rawveg/ollama-mcp」や「@etnlbck/ollama-mcp」を使う方法もありました。

(参考)MCPブリッジ手法(旧来)

| 名称 | 公式リンク | 現状 | メモ |

|---|---|---|---|

| @rawveg/ollama-mcp | GitHub リポジトリ | 参考(旧来の暫定手法) | Ollama の REST を MCP 風に橋渡し。VS Code の最新環境では byok 直結が推奨。 |

| @etnlbck/ollama-mcp | MCPディレクトリ掲載 | 参考(更新停滞の報告あり) | 実装の整合性や保守状況に注意。一般ユーザーには推奨しにくい。 |

MCPは複数のAIモデルやツールを統一的に扱うための通信プロトコルですが、OllamaはMCP非対応のため、ブリッジツールが必要でした。

しかし現在では、GitHub CopilotのbyokによるOllama直接接続が最もシンプルで推奨される方法です。

MCPブリッジの設定例(参考)

VSCodeのプロジェクト直下に .vscode/mcp.json を作成し、以下を記述:

{

"servers": {

"ollama": {

"command": "npx",

"args": ["-y", "@rawveg/ollama-mcp"],

"env": {

"OLLAMA_API": "http://localhost:11434"

}

}

}

}この方法は現在では非推奨ですが、MCPプロトコルの理解や、将来的にOllamaが公式MCP対応した際の参考として知っておくと役立つかもしれません。

まとめ

GitHub Copilotのbyok機能を使えば、VSCodeとOllamaのローカルLLMを簡単に連携できます。

デフォルト設定(http://localhost:11434)であれば追加設定は不要で、すぐに利用可能です。

過去にはMCPブリッジを使う方法もありましたが、現在ではbyokによる直接接続が最もシンプルで推奨される方法となっています。

ぜひ本ガイドを参考に、ローカルAI開発環境を構築してください。

-120x68.png)